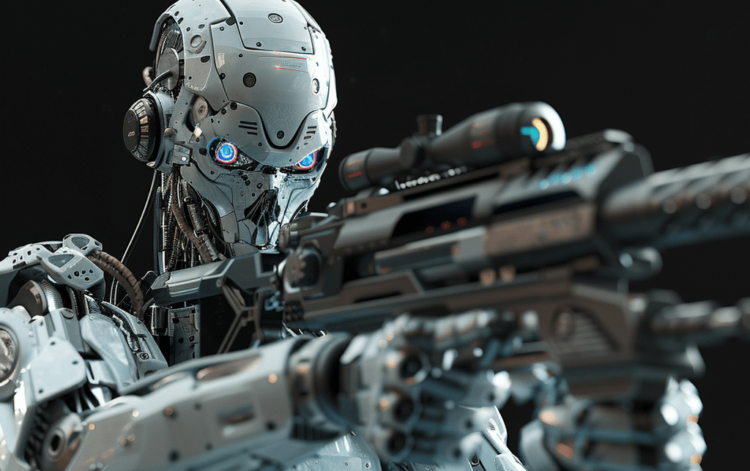

Presionar el gatillo o, en su caso, no presionarlo. Pulsar el botón, o parar. Desde un punto de vista jurídico y moral, el papel de la decisión de un soldado en cuestiones de vida o muerte es destacado e indispensable. Esencialmente, estas decisiones determinan el acto humanitario de la guerra.

No debería sorprender, entonces, que los Estados y la sociedad civil estén tratando la cuestión de las armas inteligentes autónomas (armas que pueden seleccionar y disparar objetivos sin ninguna intervención humana) como un asunto de grave preocupación.

Por otro lado, los sistemas inteligentes que sólo guían la mano que aprieta el gatillo están empezando a ganar más atención en el conjunto de herramientas de los guerreros. Y silenciosamente se han vuelto lo suficientemente sofisticados como para plantear nuevas preguntas, preguntas que son más difíciles de responder que el bien cubierto debate sobre los robots asesinos y, cada día que pasa, más urgentes: ¿Qué significa que la decisión sea en parte humana y en parte? ¿solo? ¿Parte de maquina? ¿Cuándo, si es que alguna vez, es ético tomar esa decisión como una decisión de matar?

…

De los cinco Ministerios de Defensa»Principios éticos de la inteligencia artificial.”, que se expresan como adjetivos, y el que siempre aparece primero es “responsabilidad”. En términos prácticos, esto significa que cuando las cosas van mal, alguien (un ser humano, no una máquina) tiene que hacerse cargo.

«Tvaholic. Orgulloso explorador. Fanático del alcohol. Gamer. Pionero de Internet incondicional. Incapaz de escribir con guantes de boxeo puestos».

More Stories

El estudio de la sequía plantea preguntas difíciles sobre el Fondo de Pérdidas y Daños

El artículo 23 no impone ninguna restricción a la libertad de prensa: Paul Lamm

La República Democrática del Congo retira al personal de seguridad y apoyo del ex presidente Kabila – Daily News