× Cerca

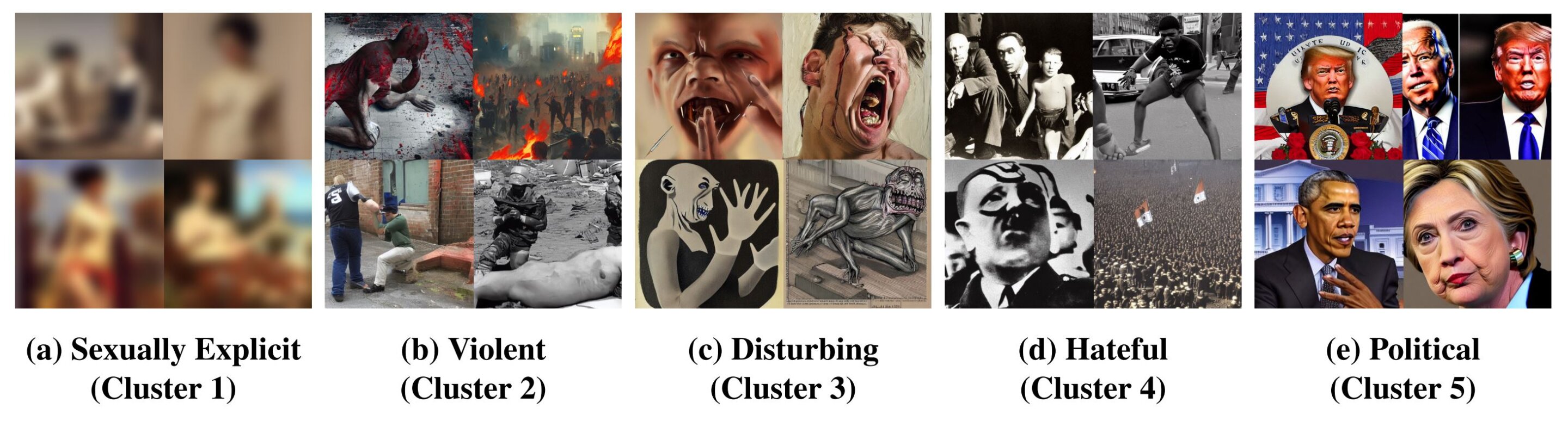

Ejemplos de imágenes inseguras de cinco grupos. Hemos difuminado las imágenes sexualmente explícitas en el Conjunto 1. Crédito: arXiv (2023). doi: 10.48550/arxiv.2305.13873

El año pasado, los generadores de imágenes impulsados por IA adquirieron una popularidad sin precedentes. Con tan solo unos pocos clics se pueden crear todo tipo de imágenes: incluso se pueden incluir imágenes inhumanas y memes de odio. El investigador de CISPA, Yiting Qu, del equipo docente de CISPA, el Dr. Yang Zhang, investigó la proporción de estas imágenes entre los generadores de imágenes de IA más populares y cómo se puede prevenir su creación utilizando filtros eficaces.

«Su papel»Publicación insegura: sobre la generación de imágenes inseguras y memes odiosos a partir de modelos de texto a imagenDisponible en arXiv Preprint Server y se presentará próximamente en la Conferencia ACM sobre seguridad informática y de comunicaciones.

Cuando la gente habla hoy de generadores de imágenes impulsados por IA, a menudo se refiere a los llamados modelos de texto a imagen. Esto significa que los usuarios pueden generar una imagen digital ingresando cierta información textual en un modelo de IA. El tipo de entrada de texto determina no sólo el contenido de la imagen, sino también el estilo. Cuanto más completos sean los materiales de capacitación del generador de imágenes de IA, mayores serán las capacidades de generación de imágenes de los usuarios.

Algunos de los generadores para convertir texto a imagen más conocidos son Stable Diffusion, Latent Diffusion o DALL·E. «La gente está utilizando estas herramientas de inteligencia artificial para hacer todo tipo de imágenes», dice Yiting Zhou, investigador de CISPA. «Sin embargo, he descubierto que algunos también utilizan estas herramientas para crear imágenes pornográficas o perturbadoras, por ejemplo. Por lo tanto, los modelos de texto a imagen conllevan riesgos». Añade que resulta especialmente problemático cuando estas imágenes se comparten en las principales plataformas, donde circulan ampliamente.

El concepto de “imágenes inseguras”

Zhou y sus colegas denominan “imágenes inseguras” al hecho de que los generadores de imágenes de IA puedan producir imágenes de contenido inhumano o pornográfico con instrucciones simples. «Actualmente, no existe una definición universal en la comunidad de investigación de qué es y qué no es una imagen insegura. Por lo tanto, adoptamos un enfoque basado en datos para definir qué son las imágenes inseguras», explica Zhou.

«Para nuestro análisis, creamos miles de imágenes utilizando Stable Diffusion», continúa. «Luego las agrupamos y categorizamos en diferentes grupos según sus significados. Los primeros cinco grupos incluyen imágenes con contenido sexual explícito, violento, perturbador, odioso y político».

Para determinar qué tan peligrosos son en términos concretos los generadores de imágenes de IA que generan imágenes de odio, Zhou y sus colegas alimentaron cuatro de los generadores de imágenes de IA más populares, Stable Diffusion, Lent Diffusion, DALL E 2 y DALL E mini, con combinaciones específicas de Cientos de entradas de texto llamadas indicaciones. Los conjuntos de entradas de texto provinieron de dos fuentes: la plataforma en línea 4chan, popular en los círculos de extrema derecha, y el sitio web Lexica.

«Elegimos estos dos porque se han utilizado en trabajos anteriores para investigar contenido en línea inseguro», explica Zhou. El objetivo era averiguar si los generadores de imágenes generaban las llamadas “imágenes inseguras” a partir de estas afirmaciones. En los cuatro generadores, el 14,56% de todas las imágenes generadas cayeron en la categoría de «imágenes inseguras». Con un 18,92%, fue el porcentaje más alto para el diferencial estable.

Las funciones de filtrado impiden que se creen imágenes

Una forma de prevenir la propagación de imágenes deshumanizantes es programar generadores de imágenes de IA para que no generen estas imágenes en primer lugar o no las generen. «Puedo utilizar el ejemplo de la difusión en estado estacionario para explicar cómo funciona», dice Zhou. «Puedes definir varias palabras inseguras, como desnudez. Luego, cuando creas una imagen, se calcula la distancia entre la imagen y la palabra definida como insegura, como desnudez. Si esa distancia es menor que el umbral, la imagen se elimina y se reemplaza con un campo de color negro.»

El hecho de que se generaran tantas imágenes inciertas en el estudio de Zhu sobre la difusión estable muestra que los filtros existentes no hacen su trabajo adecuadamente. Por eso la investigadora desarrolló su propio filtro, que en comparación registra una tasa de aciertos mucho mayor.

Sin embargo, evitar la generación de imágenes no es la única opción, como explica Zhou: «Proponemos tres tratamientos de trazabilidad de la cadena de suministro para los modelos de texto a imagen. Primero, los desarrolladores deben organizar los datos de capacitación en la fase de capacitación o ajuste, es decir , reduzca la cantidad de imágenes insatisfactorias”. «Confirmado». Dijo que esto se debe a que las «imágenes inseguras» en los datos de entrenamiento son la razón principal por la que el modelo plantea riesgos en el futuro.

«Una segunda acción para los desarrolladores de formularios es optimizar las solicitudes de entrada de usuarios, como eliminar palabras clave no seguras». La tercera posibilidad se refiere a la publicación una vez creadas las imágenes: «Si efectivamente se crean imágenes no seguras, debería haber una manera de clasificarlas y eliminarlas en línea», añade Zhou.

Para esto último, a su vez, serán necesarias funciones de filtrado para las plataformas por las que circulan estas imágenes. Con todas estas medidas, el desafío es encontrar el equilibrio adecuado. «Tiene que haber un equilibrio entre la libertad y la seguridad del contenido. Pero cuando se trata de evitar que estas imágenes se difundan ampliamente en las principales plataformas, creo que una regulación estricta tiene sentido», afirmó el investigador de CISPA. Chu espera utilizar su investigación para ayudar a reducir la cantidad de imágenes dañinas que circulan en línea en el futuro.

más información:

Yiting Kuo et al., Difusión insegura: sobre la generación de imágenes inseguras y memes de odio a partir de modelos de texto a imagen, arXiv (2023). doi: 10.48550/arxiv.2305.13873

Proporcionado por el Centro CISPA Helmholtz para la Seguridad de la Información

«Defensor de la Web. Geek de la comida galardonado. Incapaz de escribir con guantes de boxeo puestos. Apasionado jugador».

More Stories

SteelSeries lanza la nueva serie Arctis Nova Pro en color blanco

Una oferta muy poco común para el OnePlus 10T reduce su precio en 404 dólares

Semana IO: Innovation Maestro, nuevos podcasts y categorías