Los investigadores lograron avances notables en el entrenamiento de modelos de propagación utilizando el aprendizaje por refuerzo (RL) para mejorar la alineación de imágenes en tiempo real y optimizarlas para diferentes objetivos. La introducción de Diffusion Policy Optimization (DDPO), que trata la reducción de ruido como un problema de decisión de varios pasos, permite un ajuste de propagación estable en objetivos de desafío aguas abajo.

Al entrenar modelos de propagación directamente en objetivos basados en RL, los investigadores muestran mejoras significativas en la alineación de imágenes en tiempo real y la optimización de objetivos que son difíciles de articular con métodos de estimulación convencionales. DDPO ofrece una clase de algoritmos de gradiente político diseñados para este propósito. Para mejorar la alineación inmediata de la imagen, el equipo de investigación está incorporando comentarios de un modelo de lenguaje de visión grande conocido como LLaVA. Utilizando el entrenamiento de RL, lograron un progreso significativo en la alineación de las indicaciones con las imágenes generadas. En particular, los modelos cambian hacia un estilo más parecido a una caricatura, lo que probablemente esté influenciado por la prevalencia de tales representaciones en los datos previos al entrenamiento.

Los resultados obtenidos usando DDPO para varias funciones de recompensa son prometedores. Las evaluaciones de objetivos como la compresión, la incompresibilidad y la calidad estética muestran mejoras significativas con respecto al modelo base. Los investigadores también destacan las capacidades de generalización de los modelos entrenados en RL, que se extienden a animales invisibles, objetos cotidianos y combinaciones novedosas de actividades y objetos. Si bien el entrenamiento de RL brinda beneficios significativos, los investigadores notaron el desafío potencial de la optimización excesiva. El ajuste fino de las funciones de las recompensas adquiridas puede llevar a que los modelos exploten las recompensas inútilmente, a menudo destruyendo contenido de imagen significativo.

Además, los investigadores notaron la susceptibilidad del modelo LLaVA a los ataques tipográficos. Los modelos entrenados en RL pueden generar texto de tipo entero para animales, lo que engaña a LLaVA en escenarios de alineación rápida.

En resumen, la introducción de DDPO y el uso del entrenamiento RL para modelos de difusión representa un avance significativo en la mejora de la alineación de imágenes en tiempo real y la optimización de diversos objetivos. Los resultados muestran avances en compresibilidad, incompresibilidad y calidad estética. Sin embargo, desafíos como la recompensa por sobreoptimización y las debilidades en los métodos de alineación rápida requieren una mayor investigación. Estos hallazgos abren nuevas oportunidades para la investigación y el desarrollo en modelos de difusión, particularmente en tareas de generación y finalización de imágenes.

escanear el papelY proyectoY Y enlace github. No olvides unirte Sub Reddit de 26k+MLY canal de discordiaY Y Boletín electrónico, donde compartimos las últimas noticias de investigación de IA, interesantes proyectos de IA y más. Si tiene alguna pregunta sobre el artículo anterior o si nos hemos perdido algo, no dude en enviarnos un correo electrónico a [email protected]

🚀 Echa un vistazo a las herramientas de IA de 100 en el club de herramientas de IA

Niharika es consultora técnica en prácticas en Marktechpost. Ella es una estudiante de pregrado de tercer año y actualmente está cursando una Licenciatura en Tecnología del Instituto Indio de Tecnología (IIT), Kharagpur. Es una persona altamente motivada con un gran interés en el aprendizaje automático, la ciencia de datos y la inteligencia artificial y una ávida lectora de los últimos desarrollos en estas áreas.

«Defensor de la Web. Geek de la comida galardonado. Incapaz de escribir con guantes de boxeo puestos. Apasionado jugador».

More Stories

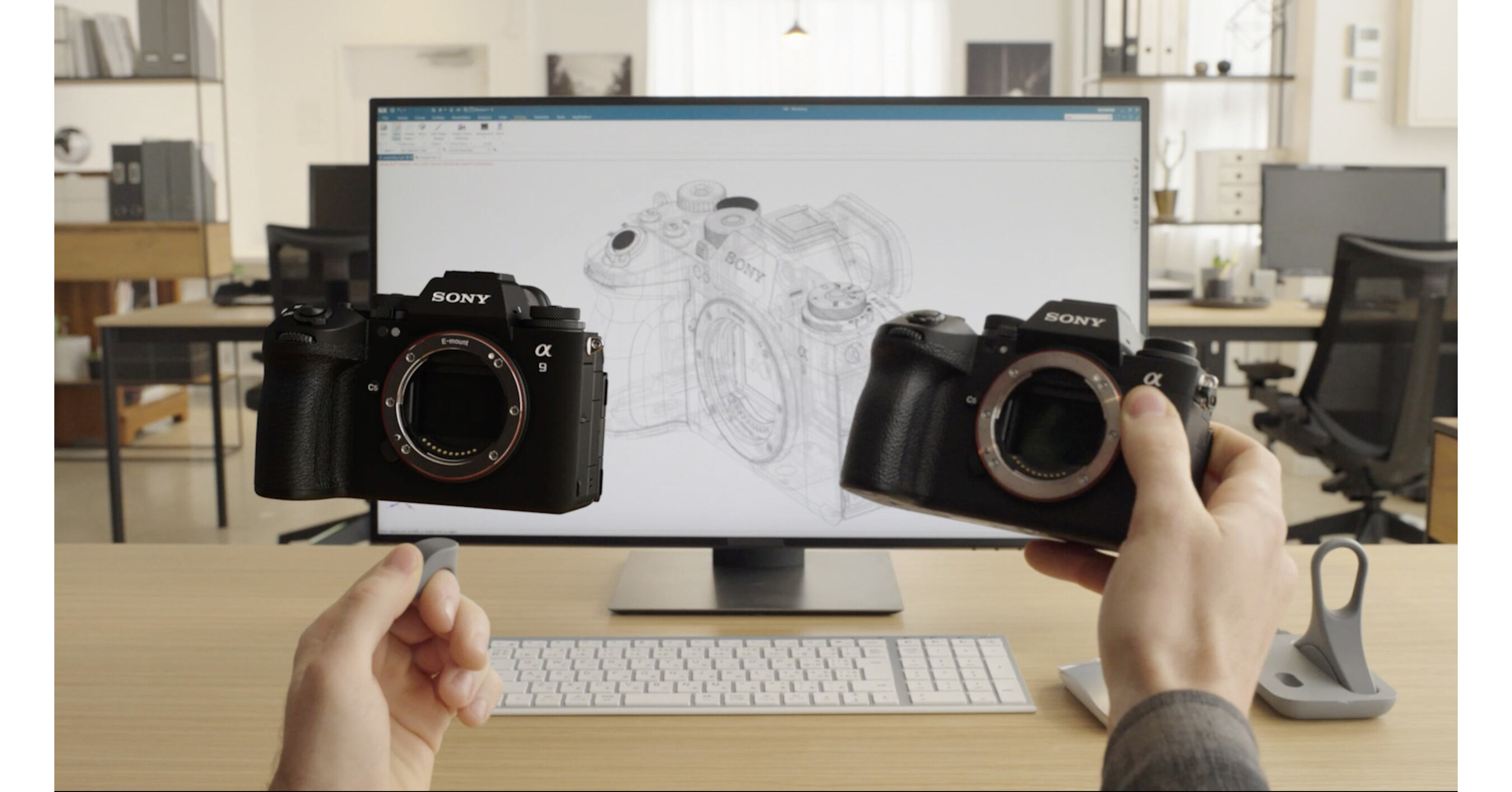

Sony y Siemens permiten una arquitectura inmersiva con un nuevo sistema de creación de contenido espacial diseñado con y para Siemens Xcelerator

Los científicos han descubierto estadísticas «extrañas» para los electrones emitidos por una intensa luz cuántica

Zapata AI da la bienvenida a Sumit Kapoor como director financiero