Tomados de la mano El lanzamiento de las PC Copilot+ AI de Microsoft ofrece una gran cantidad de funciones impulsadas por el aprendizaje automático, incluido un generador de imágenes integrado directamente en MS Paint que se ejecuta de forma nativa y convierte sus dibujos en arte.

El único problema es que necesitarás una PC nueva y brillante con Copilot+ AI para desbloquear estas funciones. Bien, para abrir Microsoft Co-crear de todos modos. Si tiene una tarjeta gráfica bastante moderna, o incluso una buena tarjeta gráfica integrada, probablemente tenga todo lo que necesita para intentar crear imágenes de IA localmente en su dispositivo.

Desde su debut hace casi dos años, los modelos Stable Diffusion de Stable AI se han convertido en la solución ideal para la generación de imágenes locales, debido a su tamaño increíblemente pequeño, licencias relativamente permisivas y facilidad de acceso. A diferencia de muchos modelos propietarios, como Midjourney o Dall-e de OpenAI, puedes descargar el modelo y ejecutarlo tú mismo.

Por este motivo, en los últimos años han surgido una gran cantidad de aplicaciones y servicios diseñados para facilitar el despliegue de modelos derivados de Stable Diffusion en todo tipo de dispositivos.

En este tutorial, veremos cómo funcionan realmente los modelos de difusión y exploraremos una de las aplicaciones más populares para ejecutarlos localmente en su dispositivo.

Requerimientos básicos:

La interfaz de usuario web de difusión estable de Automatic1111 ejecuta una amplia gama de dispositivos y, en comparación con algunos de nuestros otros tutoriales basados en IA, tampoco consume muchos recursos. Esto es lo que necesitarás:

- Para esta guía, necesitará una computadora con Windows o Linux (estamos usando Ubuntu 24.04 y Windows 11) o una Apple Silicon Mac.

- Tarjeta gráfica Nvidia o AMD compatible con al menos 4 GB de vRAM. Cualquier tarjeta gráfica razonablemente moderna de Nvidia o la mayoría de las tarjetas Radeon de la serie 7000 (algunas tarjetas de la serie 6000 de gama alta también pueden funcionar) deberían funcionar sin problemas. Hemos probado con el Tesla P4 de Nvidia, el RTX 3060 12G y el RTX 6000 Ada Generation, así como con el RX 7900 XT de AMD.

- Los controladores de gráficos más recientes para su GPU.

Fundamentos de los modelos de difusión.

Antes de pasar a implementar modelos de difusión y ejecutarlos, podría resultar útil echar un vistazo de alto nivel a cómo funcionan realmente.

En resumen, los modelos de difusión están entrenados para captar ruido aleatorio y, a través de una serie de pasos de eliminación de ruido, llegar a una imagen reconocible o una muestra de audio que represente un vector específico.

El proceso de entrenamiento de estos modelos también es bastante sencillo, al menos en teoría. Se importa un gran catálogo de imágenes, gráficos o, a veces, muestras de audio, a menudo copiadas de Internet, y se les aplica niveles crecientes de ruido. A lo largo de millones, o incluso miles de millones, de muestras, el modelo se entrena para revertir este proceso, pasando del ruido puro a una imagen reconocible.

Durante este proceso tanto los datos como sus etiquetas se convierten en vectores asociados. Estos vectores actúan como guía durante el razonamiento. Cuando se le pregunte «Cachorro jugando en un campo de césped», el modelo utilizará esta información para guiar cada paso del proceso de reducción de ruido hacia el resultado deseado.

Para ser claros, esto es una gran simplificación, pero proporciona una descripción básica de cómo los modelos de difusión pueden crear imágenes. Están sucediendo muchas cosas bajo el capó y recomendamos consultar Stable Diffusion de Computerphile. explicador Si está interesado en aprender más sobre este tipo específico de modelo de IA.

Comience con Automatic1111

Podría decirse que la herramienta más popular para ejecutar modelos de difusión localmente es la interfaz de usuario web Static Diffusion de Automatic1111.

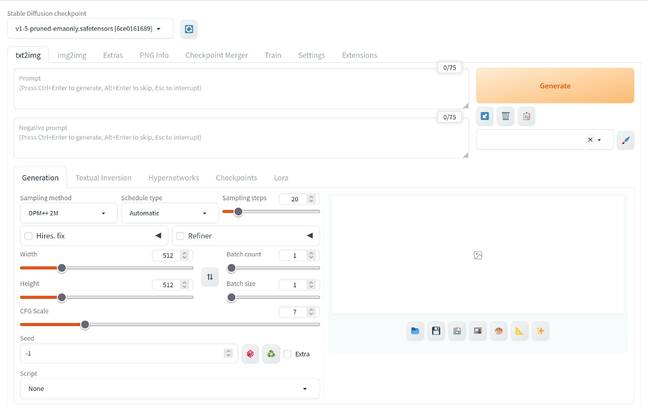

La WebUI de implementación estable de Automatic1111 brinda acceso a una amplia gama de herramientas para ajustar las imágenes generadas por IA: haga clic para ampliar cualquier imagen

Como sugiere el nombre, la aplicación proporciona una GUI simple y autohospedada para crear imágenes generadas por IA. Es compatible con Windows, Linux y macOS, y puede ejecutarse en Nvidia, AMD, Intel y Apple Silicon, con algunas advertencias que cubriremos más adelante.

La instalación real varía según su sistema operativo y hardware, así que no dude en pasar a la sección correspondiente a su configuración.

NÓTESE BIEN: Para facilitar el uso de esta guía, la hemos dividido en cuatro secciones:

- Introducción e instalación en Linux.

- Se ejecuta en los sistemas operativos Windows y MacOS.

- Utilice la interfaz de usuario web de implementación estable

- Integración y deducción

Soporte de gráficos Intel

Al momento de escribir este artículo, la interfaz de usuario web de difusión estable de Automatic1111 no es compatible con gráficos Intel de forma nativa. Sin embargo, existe una rama de OpenVINO que admite tanto Windows como Linux. Lamentablemente, no pudimos probar este método, por lo que su experiencia puede variar. Puedes encontrar más información sobre el proyecto. aquí.

Instalación de Automatic1111 en Linux: AMD y Nvidia

Para comenzar, comenzaremos con la interfaz de usuario web de Difusión estable Automatic1111, a la que llamaremos A1111 de ahora en adelante, en funcionamiento en Ubuntu 24.04. Estas instrucciones deberían funcionar con GPU AMD y Nvidia.

Si está utilizando una versión diferente de Linux, le recomendamos probar el A1111 repositorio de github Para obtener más información sobre las implementaciones de distribución.

Antes de comenzar, necesitamos instalar algunas dependencias, a saber git Y el software-properties-common desalojo:

sudo apt install git software-properties-common -y

También necesitaremos obtener Python 3.10. Para bien o para mal, Ubuntu 24.04 no incluye esta versión en sus repositorios, por lo que tendremos que agregar el PPA de Deadsnakes antes de poder extraer los paquetes que necesitamos.

sudo add-apt-repository ppa:deadsnakes/ppa -y

sudo apt install python3.10-venv -y

Nota: En nuestras pruebas, descubrimos que las GPU AMD requieren algunos paquetes adicionales para funcionar, además de un reinicio.

#AMD GPUS ONLY sudo apt install libamd-comgr2 libhsa-runtime64-1 librccl1 librocalution0 librocblas0 librocfft0 librocm-smi64-1 librocsolver0 librocsparse0 rocm-device-libs-17 rocm-smi rocminfo hipcc libhiprand1 libhiprtc-builtins5 radeontop

# AMD GPUS ONLY sudo usermod -aG render,video $USER

# AMD GPUS ONLY sudo reboot

Con nuestras dependencias ordenadas, ahora podemos abrir la interfaz de usuario web A1111 usando git.

git clone https://github.com/AUTOMATIC1111/stable-diffusion-webui && cd stable-diffusion-webui

python3.10 -m venv venv

Finalmente, podemos iniciar la interfaz de usuario web ejecutando el siguiente comando.

./webui.sh

El script comenzará a descargar los paquetes relevantes para su sistema específico, además de extraer el archivo de muestra de Stable Diffusion 1.5.

Si la interfaz de usuario web de Stable Diffusion no se carga en las GPU AMD, es posible que necesite una modificación webui-user.sh. Esto parece estar relacionado con la compatibilidad con el hardware en la versión ROCm que viene con el A1111. Según tenemos entendido, este problema debería resolverse cuando la aplicación migre a ROCm 6 o posterior.

#AMD GPUS OMLY echo "export HSA_OVERRIDE_GFX_VERSION=11.0.0" >> ~/stable-diffusion-webui/webui-user.sh

Si aún tiene problemas, visite la sección Indicadores útiles para obtener consejos adicionales.

En la siguiente sección, veremos cómo ejecutar A1111 en Windows y macOS.

More Stories

El código en los datos previos al entrenamiento mejora el rendimiento del LLM en tareas que no son de codificación

Un marco para resolver ecuaciones diferenciales parciales equivalentes puede guiar el procesamiento y la ingeniería de gráficos por computadora

Epiroc ha lanzado una nueva plataforma de perforación de producción de pozos largos